Was eine robots.txt ist!

Eine robots.txt ist eine Textdatei auf einem Webserver, die den Zugriff von Webcrawlern, auch bekannt als „Robots“ oder „Spiders“, auf bestimmte Teile der Website regelt. Sie dient dazu, den Suchmaschinen, wie Google oder Bing mitzuteilen, welche Seiten oder Bereiche einer Website indexiert werden dürfen und welche nicht. Die robots.txt-Datei basiert auf dem Robots Exclusion Standard, der von den meisten Suchmaschinen akzeptiert wird. Die robots.txt-Datei ist somit ein nützliches Werkzeug für Website-Betreiber, um die Indexierung und Sichtbarkeit ihrer Inhalte in Suchmaschinen zu steuern. In diesem Artikel werden wir uns genauer mit der robots.txt befassen und die wichtigsten Fragen dazu beantworten.

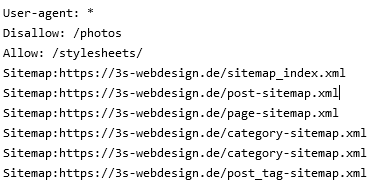

Aufbau einer robots.txt

Eine robots.txt-Datei besteht aus verschiedenen Angaben, die festlegen, welche Teile der Website für Webcrawler zugänglich oder nicht zugänglich sind. Jede Angabe besteht aus einem Befehl (z. B. „Disallow“ oder „Allow“) und einem Pfad, der angibt, welcher Teil der Website betroffen ist. Es ist also eine Regel oder Anweisung an den Webcrawler. Hier ist ein Beispiel für den Aufbau einer robots.txt-Datei:

User-agent: [Webcrawler]

Disallow: [Pfad]

Die Angabe „User-agent“ gibt an, welcher Webcrawler betroffen ist. Zum Beispiel kann „User-agent: Googlebot“ bedeuten, dass die Anweisungen für den Googlebot gelten. Die Angabe „Disallow“ definiert den Pfad oder das Verzeichnis, das für den Webcrawler nicht zugänglich ist. Wenn beispielsweise „Disallow: /verzeichnis/“ in der robots.txt-Datei steht, darf der Webcrawler das Verzeichnis „/verzeichnis/“ nicht durchsuchen.

Erstellung einer robots.txt

Die Erstellung einer robots.txt-Datei ist einfach, denn generell lässt sich eine robots.txt mit jedem beliebigem Textprogramm erstellen, welches .txt Dateien generieren kann.

Hier eine kurze Anleitung, wie man die Datei erstellt und auf die Website hochladen kann:

- Öffnen Sie einen Texteditor (wie Notepad oder TextEdit) auf Ihrem Computer.

- Erstellen Sie eine neue Datei und speichern Sie sie als „robots.txt“. (Hierbei auf die Dateiendung achten. „robots.txt.txt“ ist zum Beispiel ungültig)

- Geben Sie Ihre Anforderungen für die Suchmaschinen in die Datei ein. Regionale Anbieter brauchen zum Beispiel keinen Zugriffe von Suchmaschinen aus Russland oder Asien. Sie können verschiedene User-Agents und Disallow-Regeln hinzufügen, je nach Ihren Anforderungen.

- Speichern Sie die Datei und laden Sie sie auf den Server Ihrer Website hoch. Dafür können Sie einen FTP Client wie Filezilla verwenden. Die Datei muss im gleichen Verzeichnis liegen, wie die index.html und sich über das Web aufrufen lassen.

- Überprüfen Sie nun, ob die Datei ordnungsgemäß funktioniert, indem Sie die URL „www.example.com/robots.txt“ in Ihrem Webbrowser aufrufen. Stellen Sie sicher, dass die Datei angezeigt wird und die Anweisungen korrekt angezeigt werden.

Vorteile

Die Verwendung einer robots.txt-Datei bietet Website-Betreibern mehrere Vorteile:

- Die Kontrolle über die Indexierung: Durch die Verwendung einer robots.txt-Datei können Sie als Betreiber recht gut festlegen, welche Teile Ihrer Website von Suchmaschinen indexiert werden sollen und welche nicht. Dies gibt Ihnen die Möglichkeit, sensible Informationen zu schützen oder bestimmte Seiten von der Indexierung auszuschließen. Den Kundenbereich zum Beispiel muss keine Suchmaschine durchsuchen.

- Crawling-Effizienz: Indem Sie bestimmte Teile Ihrer Website für Webcrawler sperren, können Sie die Crawler dazu bringen, sich auf die für Sie persönlich relevanten Seiten zu konzentrieren. Dies kann die Crawling-Effizienz verbessern und sicherstellen, dass wichtige Seiten schneller indexiert werden.

- Vermeidung von Duplikaten: Wenn Sie bestimmte Seiten oder Verzeichnisse von der Indexierung ausschließen, können Sie doppelte Inhalte vermeiden. Dies kann dazu beitragen, dass Ihre Website besser in den Suchergebnissen erscheint und auch zu einer besseren Nutzererfahrung führen. Es ist also eine kleine SEO Maßnahme.

- Schutz vor Überlastung: In einigen Fällen kann der Crawl-Prozess einer Suchmaschine die Ressourcen Ihrer Website belasten. Durch die Verwendung einer robots.txt können Sie die Crawling-Frequenz für Webcrawler begrenzen und sicherstellen, dass Ihre Website nicht überlastet wird.

Nachteile

Obwohl die robots.txt-Datei viele Vorteile bietet, gibt es auch einige potenzielle Nachteile.

- Fehlkonfiguration: Wenn die Datei falsch eingestellt ist, kann dies dazu führen, dass wichtige Seiten oder Bereiche Ihrer Website von Suchmaschinen ausgeschlossen werden. Es ist wichtig, die robots.txt-Datei sorgfältig zu überprüfen, um sicherzustellen, dass sie keine unbeabsichtigten Auswirkungen hat.

- Abhängigkeit von der Kooperation der Webcrawler: Während die meisten großen Suchmaschinen die Anweisungen in der robots.txt-Datei respektieren, gibt es keine Garantie dafür, dass alle Webcrawler dies tun. Bösartige Bots können die Anweisungen ignorieren und dennoch auf nicht zugängliche Bereiche Ihrer Website zugreifen.

- Fehlende Sicherheit: Die robots.txt-Datei ist kein Sicherheitsmechanismus. Wenn Sie vertrauliche oder sensible Informationen schützen möchten, sollten Sie zusätzliche Maßnahmen ergreifen, wie z.B. die Verwendung von Authentifizierung oder Verschlüsselung.

Es ist wichtig zu beachten, dass die robots.txt-Datei nicht dazu dient, Seiten vor neugierigen Benutzern zu verbergen. Sie ist hauptsächlich dafür gedacht, den Zugriff von Webcrawlern zu steuern und die Indexierung in Suchmaschinen zu beeinflussen.

Fazit

Zusammenfassend lässt sich sagen, dass eine robots.txt-Datei ein nützliches Werkzeug ist, um die Indexierung und Sichtbarkeit Ihrer Website in Suchmaschinen zu steuern. Indem Sie bestimmte Teile Ihrer Website ausschließen oder die Crawling-Frequenz begrenzen, können Sie die Effizienz des Crawling-Prozesses verbessern und sicherstellen, dass Ihre wichtigen Seiten richtig indexiert werden. Allerdings ist es wichtig, die robots.txt sorgfältig zu konfigurieren und ihre Auswirkungen regelmäßig zu überprüfen, um unerwünschte Einschränkungen zu vermeiden.

Haben Sie Fragen?

Die Erstellung einer robots.txt-Datei ist einfach, denn generell lässt sich eine robots.txt mit jedem beliebigem Textprogramm erstellen, welches .txt Dateien generieren kann.

Eine robots.txt ist eine Textdatei auf einem Webserver, die den Zugriff von Webcrawlern, auch bekannt als „Robots“ oder „Spiders“, auf bestimmte Teile der Website regelt.